Marketing

El dilema de la protección de datos y las IA: ¿Es seguro ChatGPT?

La aparición de la herramienta ChatGPT de OpenAI ha generado gran cantidad de preocupaciones, y muy fundadas, sobre cómo se protegen los datos personales en las tecnologías basadas en IA. Tanto administraciones públicas como empresas han comenzado a tomar iniciativas y se está analizando cuidadosamente la conformidad de estas herramientas con la legislación de cada lugar en materia de privacidad. Pero yendo al grano, ¿son las IA seguras, o no? Veámoslo.

Es algo grande, nuevo y da miedo. No, no hablamos de la última serie de terror de Netflix, sino de la protección de los datos personales por las inteligencias artificiales (IA) y, en concreto, ChatGPT. La clave está en cómo estas nuevas herramientas están poniendo sectores enteros patas arriba y provocando que gobiernos, empresas y particulares nos estemos haciendo preguntas sobre la seguridad y privacidad de nuestra información personal.

Estamos ante unos recursos muy potentes, con un potencial que sus propios creadores no son capaces de prever. Como es lógico, ya hay voces en todo el mundo que están debatiendo los riesgos que plantean para la seguridad y la privacidad tanto ChatGPT como otras IA. ¿Hasta qué punto están seguros tus datos cuando usas estas herramientas? ¿Qué grado de control mantienes sobre tu información? ¿Y cómo hacer que siga estando en tus manos?

En este resumen vamos a echar un vistazo a las preocupaciones que hay en torno a ChatGPT y otras herramientas de IA, como Bard de Google o Bing de Microsoft, cómo se está adaptando el mundo a su repentino ascenso y qué se puede esperar para los próximos meses y años.

Tabla de contenidos

La política de privacidad de ChatGPT

El problema de la veracidad

Italia pone freno a ChatGPT

España abre su propia investigación sobre OpenAI

La CNIL francesa saca un plan de acción para las IA

Estados Unidos solicita la opinión ciudadana

Preocupación en el sector artístico y del entretenimiento

¿Están preparadas las herramientas basadas en IA como ChatGPT para proteger la privacidad de los usuarios?

ChatGPT, desarrollada por OpenAI, se lanzó a finales de 2022 y amasó más de 100 millones de usuarios en cuestión de un par de meses, lo que constituye de lejos la aceleración más rápida de una tecnología nueva en los últimos tiempos.

A diferencia de los motores de búsqueda tradicionales, ChatGPT es un chatbot de IA: el usuario puede hacerle preguntas y el chatbot da una respuesta muy similar a la de una persona de verdad, solo que más rápido. Puedes pedirle que escriba un email, proponga diez líneas de asunto o llamadas a la acción, redacte entradas para redes sociales, cree esquemas de artículos de blog y muchas cosas más. También puede escribir código informático, componer poemas y adivinanzas y resumir notas de reuniones.

¿Cómo lo consigue? A ChatGPT le han dado formación sobre la práctica totalidad de los datos disponibles en línea (sitios web, textos en redes sociales, libros, datos oficiales y más, todo lo que había hasta septiembre de 2021). La herramienta utiliza este almacén de información para procesar respuestas a lo que le preguntes o pidas, pero de momento no es capaz de acceder a datos en tiempo real, como sí puede un motor de búsqueda.

Pero ¿y si algunos de los datos que se introdujeron en ChatGPT no estaban destinados a uso público? ¿Acaso tiene OpenAI derecho a usar datos personales tuyos como quiera por el mero hecho de que tú publicases algo en línea hace cinco años? ¿Y qué pasa con la información que le das a ChatGPT directamente a través de tu interacción con su chat?

La política de privacidad de ChatGPT

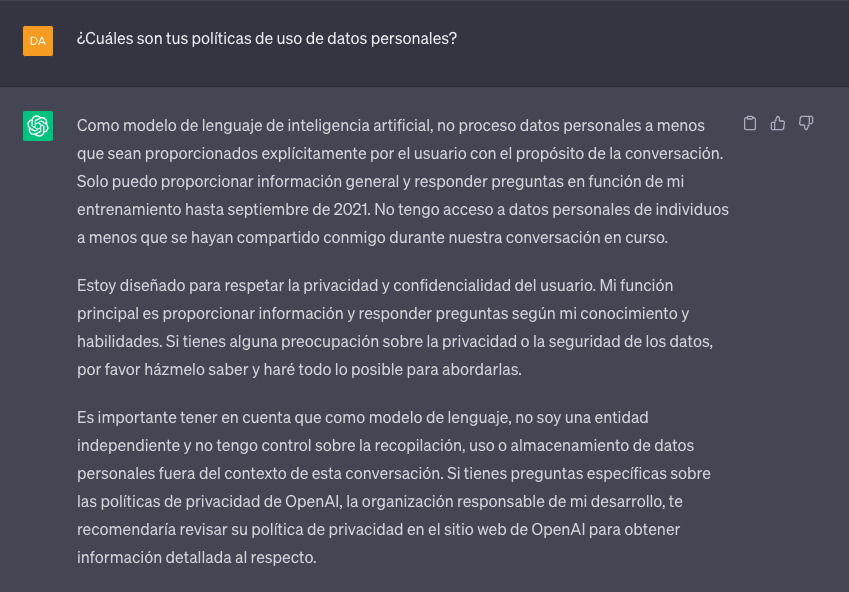

Quién mejor para responder a estas preguntas que el propio ChatGPT.

Según la propia política de privacidad de ChatGPT, recopila datos de los usuarios de tres fuentes:

La información de tu cuenta, si pagas el servicio prémium.

Toda información que introduzcas en el chatbot.

Datos de identificación de tu dispositivo, como la ubicación y la dirección IP.

Nada de esto es muy distinto de la recopilación de datos que realiza la mayoría de los demás sitios web, y las redes sociales llevan años abordando cuestiones muy parecidas.

La política de ChatGPT también declara que puede compartir estos datos con proveedores, entidades jurídicas, filiales y sus propios entrenadores de la IA. Pero si el usuario de ChatGPT indica específicamente que quiere quedar al margen de ello, no se comparte información que permita identificarle, como su número de la seguridad social o su contraseña.

Por tanto, en teoría, si bien todo lo que escribas en el chatbot puede ser usado por este último de formas imposibles de prever o controlar, queda prácticamente excluido que este material se pueda identificar como tuyo. ¿Cómo logra esto OpenAI? Según sus políticas, tras un plazo de retención, tus datos del chat se anonimizan antes de utilizarse, o, si son personales, se eliminan para proteger tu privacidad.

Pero ya entramos en terreno resbaladizo si miramos lo difícil que resulta definir “personal”. ¿Qué pasa con las preguntas sobre salud? ¿Y la información de empresa que metamos en el chatbot? La gente puede poner en ChatGPT información sin darse cuenta de que a lo mejor están proporcionando contenidos que deberían mantenerse en privado.

Para abordar esta inquietud cada vez más difundida, en mayo de 2023 OpenAI añadió una función que permite activar un control que impide que lo que pongas en ChatGPT puedan usarlo los entrenadores o modelos de IA de la empresa como material de formación. ChatGPT está diseñado para ir aprendiendo con el uso, por lo que esta función supone que la interacción que realice el usuario que la active no contribuiría a mejorar las capacidades del chatbot.

Además, el usuario puede enviarse por email su propio historial de ChatGPT, en el que tiene toda la información que haya introducido hasta la fecha.

La protección de datos personales en un mundo con IA

Cuando, en su momento, aparecieron las primeras funciones de autocompletar, los riesgos para la privacidad alarmaron a los primeros usuarios. Por ejemplo, la gente empezaba a escribir su DNI y de repente veía cómo el ordenador lo completaba.

Si todo lo que le escribes pasa a formar parte de su base de información, entonces la información que pongas en ChatGPT podría aparecerle como respuesta generativa de la IA a otra persona. Aunque esto pueda parecer inofensivo (y en muchos casos lo es), ¿qué pasa si un empleado de una empresa pone notas de una reunión para pedirle a ChatGPT que se las resuma y edite? Pues que ahora ChatGPT posee información privada de esa empresa, sus productos o sus clientes.

Imaginemos que alguien le pide a ChatGPT ideas para un regalo y una fiesta de cumpleaños de un amigo o familiar y, en la consulta, incluye la fecha de nacimiento. Ahora, ChatGPT posee este dato. También aquí OpenAI dice que ChatGPT no comparte información personal y, mediante filtros, la deja fuera de su base de información.

Sin embargo, este tipo de cuestiones ya han llevado a varias empresas importantes, como Amazon, JP Morgan, Verizon o Accenture, o algunas grandes empresas españolas, como Telefónica o BBVA, a no permitir a sus empleados el uso de ChatGPT dentro de sus actividades laborales.

“En este momento hay muchas incertidumbres acerca de la forma en que los grandes modelos de lenguaje como ChatGPT gestionan el tratamiento de datos personales, así como de los riesgos asociados para la ciberseguridad. No está claro aun como utilizan y almacenan estos sistemas basados en IA los datos introducidos, ni cómo protegen esos datos de posibles fugas, brechas de seguridad o agentes malintencionados. El proceso para eliminar los datos una vez se cargan en el sistema es ambiguo, también. Por eso, no es sorprendente ver compañías por todo el mundo publicando políticas de uso internas sobre cómo pueden usar sus empleados estas herramientas”.

Darine Fayed, vicepresidenta de legal en EMEA – Sinch

El problema de la veracidad

Además del propio uso de información personal por parte del software de IA de ChatGPT, está también el tema de la veracidad de tal información.

Tenemos “derecho al olvido”, como sostiene un crítico, pero ¿es tal derecho factible con relación a lo que ChatGPT ya sepa sobre nosotros? Y si lo que piensa que sabe sobre nosotros no fuese cierto, ¿cómo se puede corregir este error?

“Los sistemas basados en IA como ChatGPT requieren una cantidad enorme de datos, lo que significa que obtenerlos puede ser en algunos casos una prioridad mayor para sus desarrolladores que asegurarse de que respetan las leyes de privacidad. A pesar de tener herramientas listas para eliminar información confidencial y personal automáticamente, siempre hay cierta información personal que no se llega a eliminar”.

Fréderic Godin, líder de IA - Sinch Engage

Hemos hecho una prueba para ver esto en la práctica: le hemos preguntado a ChatGPT por un miembro de nuestro equipo de redacción, tecleando en el chatbot “¿Quién es [nombre apellido] de [ciudad]?”. La IA afirmó que esta persona había trabajado en cierto periódico, cosa que no era verdad. Parece que extrajo esta conclusión incorrecta porque sí publicó en él un par de columnas como firma invitada, no remuneradas. ChatGPT no ofrece ningún mecanismo para corregir este error, y esta información inexacta puede llevar a complicaciones laborales, suspicacias o incluso algo peor, y todo por algo que no es cierto.

¿Qué pasa si esto acaba siendo un problema sustancial en ChatGPT? ¿Y si alguien se pone a escribir adrede información falsa sobre otra persona, y lo hace reiteradamente?

¿Cómo se está adaptando el mundo al repentino ascenso de herramientas de IA como ChatGPT?

La Unión Europea ha actuado en pro de la protección de los datos personales y los correos electrónicos de los consumidores, con la instauración del Reglamento General de Protección de Datos (RGPD). El RGPD dispone claramente que no se pueden tomar sin más datos personales y usarlos de cualquier forma, incluso aunque el titular los haya publicado en línea.

Profesionales del email marketing de todo el mundo ya han tenido que adaptarse a la protección de la privacidad en la personalización de los emails, así como hacer el trabajo de entender unas normativas que pueden ser confusas cuando se solapan varias jurisdicciones, como las normas de privacidad de los emails de la UE y de EE. UU.

Ahora, los gobiernos, las instituciones y las compañías de todo el mundo están empezando a prestar atención a cómo protegen todas estas tecnologías emergentes los datos personales, y qué hace falta para regular su acceso a información confidencial.

“Ahora que las inteligencias artificiales han demostrado que van a provocar un profundo cambio en la sociedad, hemos empezado a ver un enfoque mayor en la protección de datos personales a todos los niveles. Por ejemplo, Microsoft está facilitando que las API de ChatGPT estén disponibles para desarrolladores en países europeos al ubicarlas en centros de datos en Europa y así respetar las leyes como el RGPD. También se observa una preocupación mayor por la privacidad en la comunidad de desarrolladores de código abierto que están trabajando en competidores de ChatGPT. El mismo cambio de paradigma ha ocurrido con otras herramientas generativas menos conocidas como Github Copilot, que genera código para desarrolladores”.

Fréderic Godin, líder de IA - Sinch Engage

Italia pone freno a ChatGPT

Entre otras cosas, las preocupaciones sobre las normas de privacidad de ChatGPT han llevado a Italia a exigir a OpenAI que deje de usar datos personales de ciudadanos italianos en su algoritmo de formación. OpenAI respondió suspendiendo su servicio en Italia mientras la investigación seguía su curso.

Italia ha enumerado cuatro inquietudes fundamentales con ChatGPT:

No hay control de edad, lo que en teoría podría exponer a menores a cualquier tipo de contenido.

Se da información inexacta sobre personas reales, como en el ejemplo que indicamos más arriba.

OpenAI no tiene ninguna base jurídica para recopilar información personal.

ChatGPT no pide permiso ni da ninguna notificación sobre el uso de datos personales.

La autoridad italiana de protección de datos personales (Garante per la Protezione dei Dati Personali), defiende que no hay fundamento jurídico alguno para usar datos personales para “entrenar” el algoritmo de IA de ChatGPT. Las personas que han puesto información suya en línea en ningún momento imaginaron ni autorizaron que se fuese a utilizar como material con el que alimentar y formar un sistema de IA para responder a preguntas procedentes de todo el mundo. ¿No debería preguntárseles al respecto?

Italia no volvió a autorizar el uso de ChatGPT dentro de sus fronteras hasta que OpenAI respondió a las consultas del regulador de una manera que este consideró suficiente, a finales de abril.

España abre su propia investigación sobre OpenAI

Otro país de la UE que ha planteado inquietudes es España. En abril, la Agencia Española de Protección de Datos (AEPD) solicitó al Comité Europeo de Protección de Datos (CEPD) que iniciase una investigación sobre las dudas en materia de privacidad en torno al software basado en IA.

De forma simultánea, España abrió una investigación a OpenAI por “posible incumplimiento” de la normativa de protección de datos.

La CNIL francesa saca un plan de acción para las IA

También en abril de 2023 Francia comenzó a investigar el uso que hace ChatGPT de los datos personales de sus ciudadanos, después de que se presentasen varias quejas.

Uno de los resultados es que en mayo el organismo francés de protección de datos, la Comisión Nacional Informática y Libertades (CNIL), publicó un plan de acción sobre inteligencia artificial para abordar las preocupaciones al respecto.

Estados Unidos solicita la opinión ciudadana

Incluso en Estados Unidos, donde tradicionalmente la protección de datos personales no está en primer plano para el gobierno federal ni para las grandes empresas, el ascenso de las IA ha generado preocupación. De hecho, en marzo más de 1800 expertos y líderes de opinión, algunos de ellos procedentes de las grandes tecnológicas, firmaron una carta abierta en la que se solicita una pausa de seis meses en el desarrollo de grandes modelos de lenguaje para permitir a todos los actores implicados desarrollar conjuntamente protocolos comunes de seguridad.

Asimismo, la administración federal ha pedido a la ciudadanía su opinión sobre los posibles aspectos regulatorios que corresponde aplicar a las IA. En un reciente comunicado de prensa, la Administración Nacional de Telecomunicaciones e Información (NTIA por sus siglas en inglés) declaró: “El presidente Biden ha dejado claro que en lo referente a las IA tenemos que respaldar la innovación responsable y a la vez garantizar unas defensas adecuadas para proteger los derechos y la seguridad de los estadounidenses”.

A mediados de mayo, el CEO de OpenAI, Sam Altman, asistió a una audiencia del congreso sobre inteligencia artificial . Aunque no se llegó a ninguna decisión durante esta primera audiencia, los senadores se mostraron de acuerdo en la necesidad de crear guías claras para regular el uso de herramientas basadas en IA y destacaron la importancia de ser proactivos y evitar algunos de los errores cometidos al comienzo de la era de las redes sociales.

Preocupación en el sector artístico y del entretenimiento

No solo las empresas tradicionales y los gobiernos están manifestando sus recelos sobre las incógnitas de la privacidad en ChatGPT.

Artistas, otros creadores de contenidos y empresas de medios de comunicación, cuya existencia depende totalmente de la titularidad de las obras y contenidos que producen, están planteando su intranquilidad ante la posibilidad de que las IA utilicen sus obras para crear otras.

El número del 29 de marzo de 2023 de The Hollywood Reporter comenta las preocupaciones por que ChatGPT y DALL-E desarrollen y escriban guiones y creen imágenes de personajes generados por IA.

Las imágenes generadas por IA están ganando mucha popularidad y provocan preocupación entre los artistas

Si bien es improbable que la toma de decisiones y la creatividad humanas desaparezcan totalmente del proceso creativo, una de las principales quejas es que la IA generativa está utilizando para producir sus contenidos las obras de artistas de carne y hueso, sin retribuir a estos últimos. En otras palabras, ChatGPT no podría “escribir” guiones ni poemas si no tuviese todo un almacén de textos de artistas reales que utilizar como modelos.

Los derechos de autor son una forma de privacidad, que establece que una persona o empresa es la dueña de un contenido concreto, y por tal titularidad posee unos derechos específicos cuyo uso puede ceder mediante licencia. Pero cuando entran en juego ChatGPT y otras herramientas de IA como DALL-E, definir y atribuir la titularidad resulta mucho más complicado. Por este motivo, las herramientas de IA han sido objeto de controversias en negociaciones sindicales, como las de el Gremio de Escritores de América (Writer’s Guild of America).

¿Qué nos reserva el futuro con respecto a la privacidad de los datos y las herramientas basadas en IA?

¿Qué piensa Mailjet de todo esto? Como ves, las cuestiones de la protección de datos en ChatGPT y las IA en general van mucho más allá del email, aunque a nuestro sector lo afecta de lleno, ya que los profesionales del marketing pueden utilizar ChatGPT para mejorar o acelerar su trabajo.

Nosotros prevemos que, conforme crezca la preocupación sobre la protección de datos, y con las grandes tecnológicas y los gobiernos de la UE en primera línea del frente, es probable que este tipo de herramientas se vean sometidas a nuevas normas y leyes en materia de privacidad, que las obliguen a incorporar más funciones para proteger a los usuarios en este sentido.

La reciente integración de un control que permite al usuario impedir que su información sensible entre en el algoritmo de ChatGPT no es, seguramente, sino el primero de muchos cambios de este tipo.

“A mayor escala, mayor responsabilidad. Creo que veremos el auge de modelos híbridos de ChatGPT donde eliminar información específica mediante una solicitud será muy fácil. Ahora mismo es algo muy difícil de realizar en una versión entrenada de la herramienta. Pero hemos visto ya a algunos de los gigantes de la industria implementar funciones que permiten a los usuarios ejercer su derecho al olvido (en los buscadores, por ejemplo). Es solo cuestión de tiempo que veamos esos mismos pasos en ChatGPT”.

Fréderic Godin, líder de IA - Sinch Engage

Al igual que cualquier otra empresa que quiera trabajar en la UE, OpenAI va a tener que adaptar la forma en que trata los datos personales de ciudadanos de la UE a la legislación europea en materia de privacidad.

¿Quieres estar al día con las últimas noticias sobre la protección de la privacidad? Suscríbete a nuestra newsletter para saber más sobre cómo afecta la normativa sobre datos a tu estrategia de marketing.